Decision Tree(의사결정나무)

**이전 study 참고

https://sports-lover-94.tistory.com/15

24.05.27 알고리즘 개념(Decision Tree)

Algorithm 종류Decision TreeClassfication/ Regression 모두 가능최대 장점: 미리 예측할 수 있음 (초반에 많이 사용) = set of rules(일련의 규칙)을 알려줌e.g. 알파고의 경우 "여기에 둬라"라는 답만 줄뿐, "왜"

sports-lover-94.tistory.com

- 어디까지 tree를 만들어야할까?

- Coding (Iris data)

# package importfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_splitfrom sklearn.tree import DecisionTreeClassifier, plot_treeimport matplotlib.pyplot as plt# Load the Iris datasetiris = load_iris()X = iris.datay = iris.target# Split the dataset into training and testing setsX_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# Initialize the Decision Tree Classifierclf = DecisionTreeClassifier(random_state=42)

# Fit the model with the training dataclf.fit(X_train, y_train)

# Predict the test datasetpredictions = clf.predict(X_test)# Print accuracyaccuracy = clf.score(X_test, y_test)print(f"Accuracy: {accuracy*100:.2f}%")# Visualize the decision treeplt.figure(figsize=(20,10))plot_tree(clf, filled=True, feature_names=iris.feature_names, class_names=iris.target_names)plt.show()

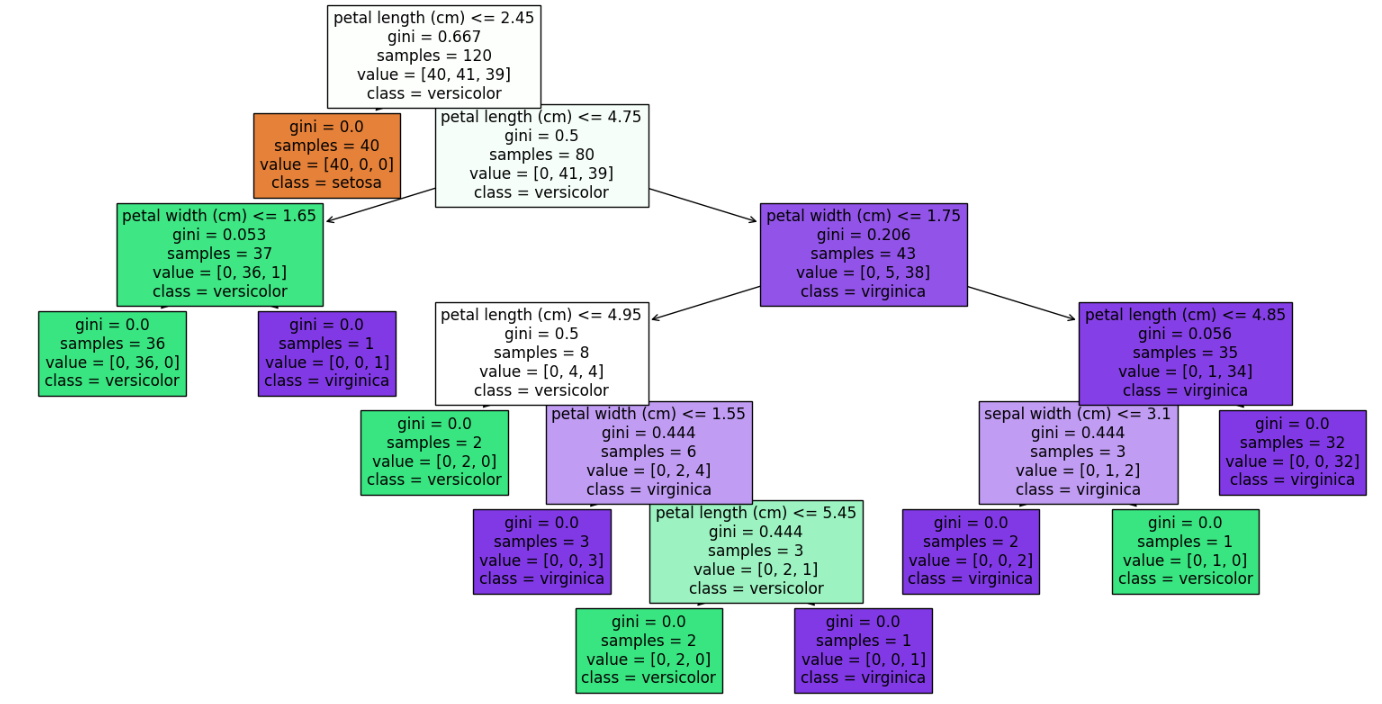

#value는 꽃종류에 따른 개수

#versicolor는 해당 class안에서 가장 많은 것 (41개)

# petal length <=2.45 기준으로 분할

#versicolor는 해당 class안에서 가장 많은 것 (41개)

# petal length <=2.45 기준으로 분할

- 위의 Decision Tree image를 이용하여 data를 잘 설명할 수 있음

- DT는 해석력이 굉장히 좋다

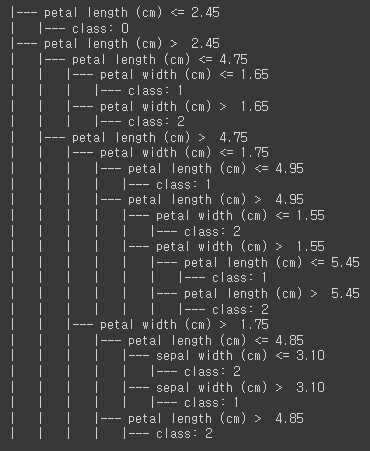

- 위에서 rule(기준, 질문)만 따오는 coding

from sklearn.tree import DecisionTreeClassifier, export_text#결정 트리 규칙을 텍스트로 출력tree_rules = export_text(clf, feature_names=iris.feature_names)print(tree_rules)

Random Forest

**이전 study 참고

https://sports-lover-94.tistory.com/16

24.05.28 Ensemble model (Bagging/ Random tree)

Cross validationstratifiedKFold()Grid Search model parameter: 일반적인 parameter 의미. 모델이 학습하면서 변화하게되는 값. 딥러닝 모델의 경우 가중치가 파라미터하이퍼 parameter: 매개변수. 모델의 학습 전에

sports-lover-94.tistory.com

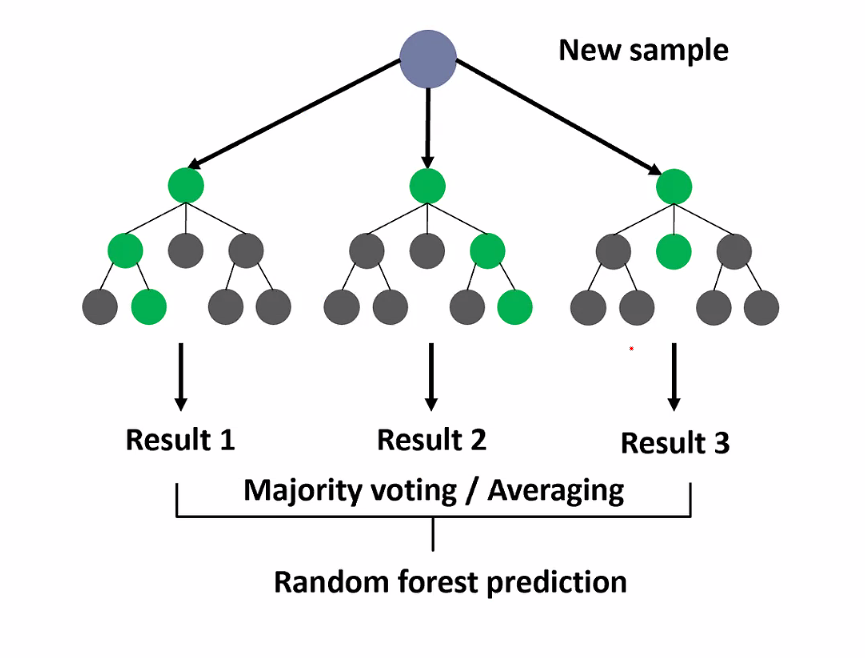

- Decision Tree(DT)가 모여 Random Forest를 이룸

- New sample이 input되면 각각의 DT에서 산출하고 각 result를 voting/average하여 분석

- estimators(트리 개수)와 features 개수가 중요한 설정 factor

- 단점: overfitting되는 경향

- 만약 30개의 feature를 기반으로 하나의 DT를 만든다면, 30개의 feature 중 5개를 선택하여 하나의 DT를 구성

- 이를 반복하여 여러개의 DT를 구성

- 여러 DT에서 나온 예측값 들 중 가장 많이 나온 값을 최종 예측값으로 선정(다수결)

- 다수결의 원칙 = 앙상블(Ensemble), 의견을 통합하거나 여러가지 결과를 합치는 방식

- Coding (Iris data)

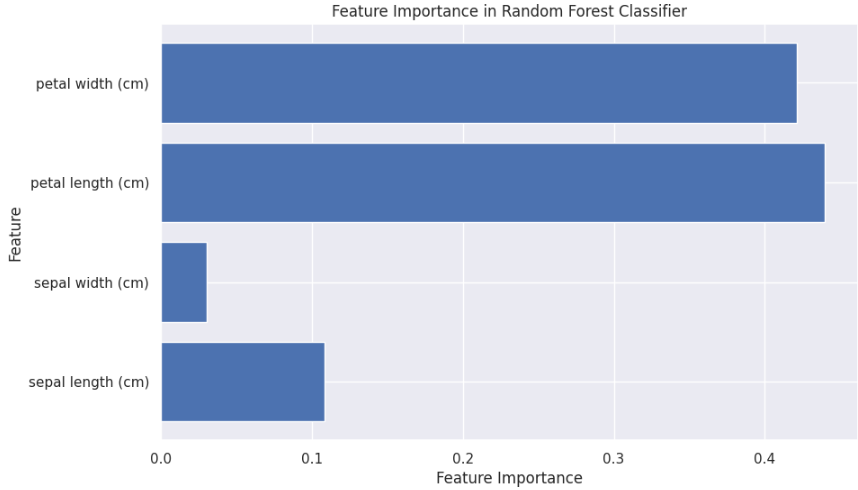

- RT에서 중요한 factor: estimators, features 개수

- features 개수를 적게 설정해줘야 overfitting 방지됨

- 어떤 것이 가장 좋을지는 돌려봐야 알 수 있음

from sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_splitfrom sklearn.ensemble import RandomForestClassifierfrom sklearn.metrics import accuracy_scoreimport matplotlib.pyplot as pltimport seaborn as sns; sns.set() # For a nicer plot style# Load the Iris datasetiris = load_iris()X = iris.datay = iris.targetimport pandas as pd

# 데이터프레임으로 변환 (확인차)df = pd.DataFrame(X, columns=iris.feature_names)

print(df.head())# Split the dataset into training and testing setsX_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# Initialize the Random Forest Classifierrf_clf = RandomForestClassifier(n_estimators=100, random_state=42)# estimators: 트리 개수# 100 trees in the forest# features 개수는 default 값으로 설정됨# print(rf_clf.max_features)로 출력하면 features 값나오고 지정도 가능 (max_features=0.5 --> 50% 설정)import mathresult = math.sqrt(9) # 제곱근 함수print(result) # Outputs: 3.0# 데이터의 특성 수를 구하고, 'auto'에 해당하는 실제 값을 계산합니다.import numpy as npn_features = X_train.shape[1] # feature 수max_features = int(np.sqrt(n_features)) # 'auto' 설정에 따른 실제 max_features값 계산

# print(n_features)print(f"max_features 수: {max_features}")# Fit the model with the training datarf_clf.fit(X_train, y_train)# Predict the test datasetpredictions = rf_clf.predict(X_test)# Calculate accuracyaccuracy = accuracy_score(y_test, predictions)print(f"Accuracy: {accuracy*100:.2f}%")# Feature Importancefeature_importances = rf_clf.feature_importances_features = iris.feature_namesplt.figure(figsize=(10, 6))plt.barh(range(len(features)), feature_importances, align='center')plt.yticks(range(len(features)), features)plt.xlabel('Feature Importance')plt.ylabel('Feature')plt.title('Feature Importance in Random Forest Classifier')plt.show()

QUIZ

- House price data로 DT modeling해서 regression 해보기 (DT_regression 참고)

Deep vs. Machine learning

- 딥러닝

- Neural networks based

- 데이터에서 자동으로 복잡한 특징을 학습

- 복잡한 데이터 구조와 패턴 학습이 가능. 비선형성 (활성화 함수에서 쓰임. e.g. ReLu)

- 일반적으로 성능이 더 좋다고 알려져 있음

- 머신러닝

- 상대적으로 간단한 데이터 구조에서 잘 작동

- 선형성, 분포 등에 대한 가정을 기반

- 모델의 성능은 선택된 특징의 질에 크게 의존

- Feature extraction 과정에서 도메인 지식이 중요

Neural Network (NN) - 6/10 내용과 이어짐

- Bias node(편향노드)

- 선형 회귀 모델에서의 절편(intercept)

- 입력층과 은닉층에 존재

- 선형 회귀 모형의 intercept(절편)와 비슷한 역할

- Bias node에서 출력되는 값: 1

- 신경망 모형의 학습

- 비용함수를 최소화하는

QUIZ

- House price data로 NN modeling해보기

- Wine data로 PyTorch를 이용하여 다중 신경망 모델 만들기

from sklearn.datasets import load_winefrom sklearn.model_selection import train_test_splitimport torchfrom sklearn.preprocessing import StandardScaler

import torch.nn as nnimport torch.optim as optim

# scikit-learn 라이브러리를 사용하여 와인 데이터셋을 불러오기wine = load_wine()x = wine.datay = wine.target

# 데이터셋을 PyTorch 텐서로 변환(독립변수는 float, 종속변수는 long 타입으로 지정)x_tensor = torch.tensor(x, dtype=torch.float32)y_tensor = torch.tensor(y, dtype=torch.long)

# 데이터셋을 학습용과 테스트용으로 나누기(테스트데이터셋 20%)x_train, x_test, y_train, y_test = train_test_split(x_tensor, y_tensor, test_size=0.2, random_state=42)

# 학습용과 테스트용 독립변수를 학습용의 평균과 표준편차로 정규화하기scaler = StandardScaler()x_train = torch.tensor(scaler.fit_transform(x_train), dtype=torch.float32)x_test = torch.tensor(scaler.transform(x_test), dtype=torch.float32)

print("Training set:", x_train.shape, y_train.shape)print("Testing set:", x_test.shape, y_test.shape)#class NeuralNet(nn.Module):def __init__(self):super(NeuralNet, self).__init__()self.layer1 = nn.Linear(10, 20)self.layer2 = nn.Linear(20, 7)self.output = nn.Linear(7, 2)

def forward(self, x):x = torch.relu(self.layer1(x))x = torch.relu(self.layer2(x))x = torch.softmax(self.output(x), dim=1)return x

model=NeuralNet()criterion = nn.CrossEntropyLoss()optimizer = optim.SGD(model.parameters(), lr=0.1)

'TIL(2024y) > Deep learning' 카테고리의 다른 글

| 24.07.08 Auto encoder (0) | 2024.07.08 |

|---|---|

| 24.07.03 CNN (0) | 2024.07.06 |

| 24.07.01 Deep learning (구조 및 역할) (0) | 2024.07.01 |

| 24.05.30 SLP/ MLP (0) | 2024.05.30 |

| 24.05.29 Ensemble model/ Neural network (0) | 2024.05.29 |